Newsletter n°47 – février 2012

MegaUplaod est hors d’état de nuire ! Nous ne nous en réjouissons pas. Ce n’est pas en supprimant le principal moyen qu’avaient trouvé les internautes pour satisfaire leur soif de consommation de biens culturels, musique et vidéo, sans se ruiner, que l’on peut résoudre le problème.

Car problème il y a, et solution il n’y a toujours pas aujourd’hui, c’est tout aussi certain.

Demain, quelles formes prendront les détournements ?

Va-t-on assister à une purge mondiale des contenus dits illégaux sur l’Internet, alors que l’écosystème d’offres légales diversifiées et accessibles à des prix raisonnables n’est toujours pas en place ? Ce possible passage en force pourrait provoquer bien des dégâts.

Déjà, suite à Hadopi, le piratage s’était déplacé du peer to peer vers le streaming. Demain, vers quoi ira-t-il ? Le développement des VPN cryptés est un bel exemple. Les réglementations et mesures autoritaires mises en place depuis 2004 n’ont eu quasiment aucun effet sur le fond. Il faut l’admettre, réfléchir, débattre, innover.

C’est un nouvel équilibre, de nouveaux modèles économiques qu’il faut construire, pas le maintien en l’état d’un système qui cherche à perdurer depuis plus de 30 ans, le temps des vinyles et autres VHS. Le monde du numérique, par sa capacité d’échange et de copie démultipliés, doit inventer un nouvel écosystème, revisité, adapté aux nouveaux médias. Le développement de l’imprimerie n’a pas permis aux moines copistes de se maintenir, ouvrant la voie au formidable développement de l’éducation, du savoir, de nos sociétés de la connaissance.

C’est une nouvelle étape de ce processus, de cette nécessaire mutation que nous vivons aujourd’hui, c’est ce que les jeunes générations réclament, consommateurs avides de biens culturels, ils attendent une offre adaptée à leurs modes de consommation, alors qu’on leur propose de soumettre les technologies aux règles et répartitions de valeurs d’avant hier.

Où en sont les ayants droit dans leurs réflexions ? Voici ce que vient de déclarer Bernard Miyet, président du directoire de la Société des auteurs, compositeurs et éditeurs de musique (Sacem) à Édition Multimédia : "La Sacem a rapidement pris la mesure de l’impact de la diffusion numérique pour la filière musicale, qu’il s’agisse des conséquences potentielles du piratage, de la nécessité de favoriser le développement des sites légaux ou de l’exigence de modernisation de ses propres outils." (janvier 2012).

Cette newsletter est consacrée à ce thème, dans une optique de création de valeur, pas de protection des acteurs en place. Diffusons, Valorisons, Innovons !

Bonne lecture. Si d’autres opinions et réflexions argumentées souhaitent s’exprimer dans cette newsletter, nous l’acceptons avec enthousiasme, prenez contact et adresser vos textes http://www.forumatena.org/?q=contact

Philippe Recouppé, Président du Forum ATENA

En milliards d’euros, c’est le nombre de règlements annuels en France… et 16 Milliards d’ordres de paiement !

|

Sous ce titre, évidemment inspiré de l’actualité, lire par exemple http://bit.ly/wivoS4, nous voulons parler ici de deux des points qu’un créateur souhaite généralement que l’on ne fasse pas de son travail : modifier ou transformer son œuvre en le recopiant (droit moral) et le commercer ou faire commercer (droit patrimonial) sans qu’il ait son mot à dire. Cette problématique a existé de tout temps mais elle a été amplifiée avec l’avènement d’Internet et du Web qui proposent d’extraordinaires facilités en copie, en visibilité et en transfert de contenus audiovisuels et cinématographiques numérisés par tout un chacun. L’évènement historique dans la jeune histoire d’Internet qu’ont constitué l’arrêt subit des DNS de la société MegaUpload et la destruction annoncée de données privées sur ces serveurs, couplé avec les débats autour des lois (en cours de) mises en place – SOPA, PIPA, ACTA, HADOPI – a mis en avant l’incroyable réactivité, dans un sens ou dans un autre, des internautes, des associations impliquées, des filières industrielles et des législateurs dès lors qu’il s’agit de droits d’auteur d’œuvres musicales, audiovisuelles, cinématographiques… Alors que certains détenteurs de propriétés industrielles auraient bien aimé que l’on s’occupe avec autant d’empressement et de force légale des contrefacteurs bien mis en avant, voire relayés, par les services « Shopping » des outils de recherche bien connus sur Internet. Le sujet est sensible. Aussi pour les spécialistes, cet article est sans doute trop simplifié et l’auteur trop peu compétent pour débattre globalement des droits d’auteur. Je souhaite ici simplement initier et soumettre à discussion certains aspects qui touchent directement la distribution des contenus audiovisuels et cinématographiques numérisés sur Internet (pour un regard détaillé et complet de ce sujet, voir la thèse de Sophie Boudet-Dalbin soutenue le 12/12/2011 http://bit.ly/rDE0Z8). Mon premier souhait est de montrer qu’il serait particulièrement intéressant, pour approfondir ce sujet socio-économiquement très vaste, que des historiens spécialisés étudient les « comment cette problématique des droits d’auteur étendue à cette technologie de rupture, que sont les reproductions numériques et le medium Internet accessibles à tous, a été traitée lors de l’apparition de précédentes techniques de rupture » : de la photographie jusqu’au lecteur-enregistreur en passant par le scanner, de la TSF jusqu’aux transports électroniques en passant par le fichier numérique. A l’image de l’excellent numéro de la revue Les collections de l’Histoire d’octobre-décembre 2005 consacré à l’écriture : on y apprend que si la copie a toujours existé elle a été multipliée dès l’invention (ou popularisation) de la sténographie à la fin du XVIe siècle en Angleterre. A l’époque, il s’agissait surtout de rejouer les pièces des grands auteurs dans les provinces. De même, une étude historique sur le comportement socio-économique des consommateurs des œuvres serait tout aussi indispensable : aujourd’hui, une partie de la nouvelle génération se contente souvent de regarder des œuvres en très mauvaise qualité et/ou sans confort et il n’est pas sûr que ce soit dû à la seule gratuité. Je ne sais pas s’il en existe mais je suis convaincu qu’à défaut d’être complète, toute évolution légiférée ou qui nécessite une régulation ne peut être consistante « qu’à ce prix », qu’avec ce travail préalable. A ce propos, Molière aurait-il été connu s’il n’avait pas été copié ? C’est une grande question qui en appelle d’autres sur notre sujet : les « téléchargeurs » illicites de films ne sont-ils pas de grands acheteurs de DVD ou de tickets de cinéma ? Ne font-ils pas partie des principaux acteurs du « bouche à oreille », le fameux « spray the word » que les spécialistes du « e-marketing » tentent de développer sur Internet ? Y-a-t-il eu des études sur ces questions ? Si nous revenons à l’actualité, le projet MegaUpload + UbicMedia aurait pu contribuer à répondre grâce aux millions d’usagers mensuels de MegaUplaod qui devait tester un modèle nouveau. Emmanuel Gadaix de MegaUpload a déclaré au Sénat le 11 janvier 2012 : « nous allons faire un essai avec eux (UbicMedia) pour la distribution d’œuvres et les mettre en place de manière totalement légale avec le contrôle complet des Ayants droit afin qu’ils puissent utiliser notre plateforme en tant que site d’hébergement et ainsi profiter de nos centaines de millions d’utilisateurs et de toute la présence globale que nous avons. », et j’ajoute, en permettant de tester tous les modèles socio-économiques possibles. Une étude européenne tend à montrer par exemple que de 10 à 20 % au moins des « téléchargeurs » dits illicites auraient payé l’auteur ou le producteur, ce qui représente un chiffre d’affaires égal voire supérieur au Box Office mondial. Brièvement et très schématiquement, le terme « droits d’auteur » apparaît (pour la 1ère fois) en 1838 en France et tend à s’internationaliser avec la Convention de Berne à partir de 1886 signée par 10 pays puis jusqu’à environ 180 pays en 2009. Elle a donné une position centrale à l’auteur, alors que le « copyright » anglo-saxon s’attache à la protection de l’œuvre elle-même. Les droits ont été étendus et renforcés avec les nouvelles technologies durant le XXe siècle. En ce siècle, ils sont plutôt remis en cause car l’essor de cette dernière rupture, l’économie numérique, semble donner naissance (ou libérer ?) à de nouveaux comportements socio-économiques aussi bien des auteurs que des consommateurs au détriment de filières intermédiaires. Ces dernières doivent faire face à ce nouveau paysage ; schématiquement, elles ne peuvent que s’orienter vers une concentration de ses propres acteurs y compris les sites de VoD (catalogues, « agrégateurs »…) qui n’ont fait que reproduire grâce à l’application Web au-dessus d’Internet, le modèle antérieur : producteurs, agents internationaux, distributeurs locaux, exploitants et en gardant partiellement ou totalement les règles d’exclusivité. C’est le règne des hyper-marchés Web, du e-commerce étendu aux biens immatériels. Le mode de répartition légale et équitable des revenus pour les Ayants droit y est presque insoluble dans ces modèles qui généralement demandent au consommateur de s’abonner au site et non d’acheter un visionnement du contenu. Elle est généralement complétée par une répartition elle-même très difficilement contrôlable des revenus publicitaires. Elle est de plus amputée des coûts de mis en avant marketing des contenus dans ces mêmes sites ! Encore schématiquement, s’agissant du bien matériel en Amérique du Nord, le leader NetFlix et d’autres ont profité de la « first sale doctrine » qui lui permet d’acheter des DVD puis de les louer « physiquement » à volonté sur Internet sans rien devoir ni avertir les Ayants droit de toute nature. Il en est de même pour la revente de DVD par les Musées, leur location par les Médiathèques, etc… En Europe et autres régions, cela n’est pas légal, et cela a participé aux fameux débats sur la copie privée. Lorsque NetFlix a étendu son site de location de DVD à la fonction de VoD, ce principe ne pouvait plus s’appliquer, d’une part parce que cette doctrine ne s’applique qu’aux biens matériels et d’autre part parce qu’elle suppose une utilisation unique simultanée du DVD acheté. Principe difficilement prolongeable sur un site Web de VoD : imagine-t-on chacun des centaines voire des milliers d’internautes devant attendre que tous les autres internautes ayant déjà acheté le droit de voir aient fini de le voir ! C’est alors le retour aux marges garanties (voir l’article des Echos des Finances n° 20990 du 8 août 2011 sur la mésaventure de NetFlix avec Starz qui possédait 22% des contenus mis en VoD) et donc la recherche d’un prix de revient soutenable, prix déjà amputé par les coûts des techniques centralisées de streaming sur Web. En dehors peut-être de la concentration et de ses revenus publicitaires, ce modèle devient insoutenable. Une piste, peut-être saine, pour une évolution complète et consistante de la distribution et les visionnements des contenus numériques à valeur marchande sur Internet, rappelons que c’est notre propos ici, est de considérer comme postulat qu’Internet est un nouveau medium pour un nouveau marché, totalement complémentaire au Cinéma et TV, comme l’ont été et démontré par leur immense succès, le VHS, le CD et le DVD qui pourtant nécessitaient l’achat d’équipements à la maison. Dans ce cas, si l’on revient à nos deux préoccupations de l’introduction, un auteur ou producteur de cette génération pourrait imaginer : « (a) En ce qui concerne la reproduction de mon œuvre, j’accepte une certaine transformation afin que le fichier de mon contenu numérisé (pseudo-master numérique) puisse être diffusée vers le plus grand nombre des internautes (droit de reproduction) et je contrôle cette qualité (droit moral). » Ceci revient à considérer Internet comme une salle de cinéma universelle où se côtoient tous les films dont la visibilité dépendra des internautes eux-mêmes : les fans sur les réseaux sociaux, les blogueurs prescripteurs, les auto-distributeurs comme les hébergeurs ou les utilisateurs de réseaux P2P, ou encore les professionnels en marketing ou agences de communication spécialisés dans le numérique. Ce marché existe réellement potentiellement en terme de comportement des internautes : diverses études tendent à démontrer d’une part que 2/3 des internautes acheteurs ou vendeurs sur Internet le seront encore plus activement s’ils peuvent à la fois acheter et vendre et d’autre part qu’entre ½ et 2/3 des internautes achèteraient volontiers sur le conseil d’« amis » dans les réseaux sociaux. En continuant l’analogie avec les spectateurs en salle de cinéma, l’accès au film sera donc un ticket d’entrée dans une salle virtuelle qui fonctionne 24/24 et depuis n’importe quelle connexion Internet. Ces tickets à usage unique peuvent être achetés par lot et revendus ou … la créativité sera de mise sur ce point. Le Créateur peut demander à ce qu’un usage soit multiple (par exemple l’équivalent du déchirement des quatre coins d’un ticket…). Un ticket peut être aussi un carton d’invitation à une séance privée entièrement contrôlée par l’Ayant droit. Enfin, les visionnements ainsi achetés ou permis sur invitation doivent pouvoir être consommés par tout un chacun quelque soit la connexion Internet disponible : si la connexion d’un Internaute est supérieure au taux d’encodage du film décidé par le Créateur, alors il peut le voir immédiatement, si elle inférieure, il devra attendre plus ou moins longtemps avant de commencer de voir mais à la même qualité que celle désirée par le Créateur (droit moral). Si le film est sur dispositif hardware (clés usb, hdd, dvd…), le film sera vu immédiatement. Ce système respecte les « droits de suite » de tout Créateur ou de ses représentants (Ayant droit) et peut être utilisé pour une « first sale doctrine » étendue à Internet pour les sites de e-Commerce de contenus numérisés virtuels. En effet, les technologies architecturales (sécurité système) peuvent permettre de garantir la pérennité du quadruple lien (sécurité métier) entre l’Ayant droit, le contenu numérisé, l’internaute (même anonyme) et, s’il y a, le(s) revendeur(s)/prescripteur(s), où que se trouve le contenu et quelque soit le dispositif de visualisation (sécurité applicative). Pour conclure et en espérant une suite à cet article clairement conduit par l’actualité donc forcément incomplet et teinté de subjectivité, citons la Spedidam, société de perception et de distribution des droits des artistes-interprètes, qui écrit (29/01/2012) en concluant son rapport 2011 : « Les plateformes de diffusion de musique sur Internet, comme celles qui ont été labellisées en 2011 par Hadopi, font un commerce légal mais inéquitable. » Dans cette voie de plateformes Web e-Commerce, il est certain que dans l’audiovisuel et le cinéma où les droits sont très complexes, « l’inéquitabilité » deviendrait la règle et la « légalité » incontrôlable (voir à ces sujets, la newsletter du 6/02/12 d’Electronlibre.info). C’est ce type de solution, qui provient de 4 ans de recherches totalement orientées vers les Créateurs et Ayants droit « internautes » et vers une expérience confortable des internautes spectateurs, qu’offre le système PUMit de ma société UbicMedia. Cette solution est proposée, en Amérique du Nord et dans les pays BRIC, aux éditeurs de sites de partage et gestion de documents (un partenariat a commencé avec BOX, un des leaders américains), aux studios producteurs et distributeurs (un partenariat a été signé avec Starz Media et elle est étudiée et proposée aux Majors), aux éditeurs d’outils de Post-Production, aux sociétés de e-marketing (un accord est signé avec CrowdStarter) et aux hébergeurs offrant des services comme Amazon, Akamaï, EMC et bien sûr MegaUpload qui nous a contactés dans ce contexte pour devenir la plus grande salle de cinéma du monde, pleinement légale et équitable puisque contrôlée par les Ayants droit eux-mêmes. Déjà, en ce début d’année, UbicMedia devait y mettre pour le compte de Starz Media des séries numérisées traitées par PUMit et ainsi bénéficier immédiatement des millions de spectateurs mensuels potentiels ! Dans cette affaire MegaUpload doté du système PUMit, les Créateurs ont perdu une excellente solution pour commercialiser leurs œuvres, sans doute la plus grande salle de cinéma dont ils pouvaient rêver. Les sites de VoD « online » ont gagné une concurrence en moins et s’attachent à récupérer cette audience, ce qu’ils affirment observer ces jours. C’est peut-être bien là un aveu que des utilisateurs de sites dits illicites mais de qualité accepteraient de payer s’ils y trouvaient légalement les films qu’ils recherchent ou qui leur sont proposés. Clairement, leur motivation ou le fait de leur entrée sur ces sites n’était pas du tout seulement la gratuité. Pourquoi donc ? est la seule et bonne question pour déterminer les nouveaux modèles socio-économiques sur Internet. Alain ROSSET, président d’UbicMedia SAS et INC.

Internet est une merveille, incontournable et indispensable. L’impact sur nos modes de travail est tel que se remémorer nos coutumes vieilles de seulement quinze ans nous ramène à un autre temps. Souvenez-vous : Or Internet est un être fragile. Non, pas seulement à cause de grippages ou congestions passagères. Deux écueils au moins sont identifiés. Le premier est lié au mode de routage entre les réseaux, construit sur un principe d’annonces (protocole BGP) et ouvert à toute déclaration fallacieuse à même de détourner le trafic. Le deuxième nous intéresse plus particulièrement ici. Il s’agit de l’attribution des adresses IP d’Internet et de la gestion des serveurs de nom de domaine où toute erreur éteint les domaines affectés. Cette tables sont sous l’autorité d’un organisme, l’ICANN. À lui le pouvoir de dire non, en l’occurrence de "blacklister" un site jugé indésirable. La rapidité de la coupure de MegaUpload illustre ce pouvoir absolu. Bien. Sauf que le bât blesse quand cet organisme n’est pas indépendant mais sous l’autorité d’un Êtat. Il nous faut alors quitter le modèle Greenwich pour nous rapprocher d’un autre comme le réseau de satellites GPS. Nous sommes largement tributaires de services – heure, localisation Mais que me dit-on ? MegaUplaud était fin prêt pour le lancement d’une nouvelle offre commerciale ? Rassurez-moi, il n’y a là aucun lien ? Internet : indispensable mais ô combien fragile ! Jacques BAUDRON, Secrétaire Adjoint Forum Atena, jacques.baudron (at) ixtel.fr

Préambule Le président de l’association « Forum Atena » accueille les participants pour l’intervention assurée par le cabinet d’avocats Iteanu et plus particulièrement par maître Raoul Fuentes. Les propos qui suivent sont tirés de la transcription de cette intervention. Exposé L’Ordonnance n°2011-1012 du 24 août 2011 relative aux communications électroniques est un texte ayant valeur de loi élaboré par le pouvoir réglementaire sur autorisation expresse du parlement français. Elle transpose le « Paquet Télécom », comportant notamment la directive européenne 2009/136/EC du 25 novembre 2009. L’ordonnance du 24 août 2011, par les obligations qu’elle intègre à la législation sur les données personnelles, est une révolution dans le domaine de la sécurité informatique : la pratique de la loi du silence en cas d’attaque ou de fuite(s) de données cède désormais la place à l’obligation légale de divulgation des manquements constatés à la sécurité des données personnelles. Pour saisir la portée de cette modification légale, il est intéressant de remonter à sa source et de comprendre l’esprit dans lequel cette obligation a été prévue. Genèse de l’obligationLa directive européenne 2002/58/EC (directive "vie privée et communications électroniques") posait en réalité le cadre de cette obligation. Dans son considérant 20 le législateur européen indiquait « qu’il convient que les fournisseurs de services prennent les mesures appropriées pour assurer la sécurité de leurs services, le cas échéant conjointement avec le fournisseur du réseau, et informent les abonnés des risques particuliers liés à une violation de la sécurité du réseau. De tels risques peuvent notamment toucher les services de communications électroniques fournis par l’intermédiaire d’un réseau ouvert tel que l’Internet ou la téléphonie mobile analogique. » L’article 2 c) de la directive précise la directive de 2002, en introduisant les notions de « violation de données à caractère personnel », une définition des services concernés, et les modalités de l’obligation de notification qui sont reprises par l’Ordonnance. Mise en œuvre : qui, quoi ?Le texte résultant de l’Ordonnance pose une difficulté d’interprétation quant à sa portée. D’autres éléments nous semblent plaider pour une interprétation étendue au-delà des seuls opérateurs :

Le contenu de l’obligation de notification telle qu’elle résulte de l’ordonnanceQue dit la loi française et plus particulièrement la loi dite « Informatique et Libertés » de 1978 sur le sujet ?

Il faut rappeler ici que l’article 34 de la loi, qui existe depuis l’origine de la loi en 1978, prévoit une obligation de sécurité à la charge de tout responsable de traitement de données personnelles en ces termes : « Le responsable du traitement est tenu de prendre toutes précautions utiles, au regard de la nature des données et des risques présentés par le traitement, pour préserver la sécurité des données et, notamment, empêcher qu’elles soient déformées, endommagées, ou que des tiers non autorisés y aient accès. ».

L’article 34 Bis nouveau de la loi n° 78-17 du 6 janvier 1978 définit le champ d’application de l’obligation de notification en indiquant que « Le présent article s’applique au traitement des données à caractère personnel mis en œuvre dans le cadre de la fourniture au public de services de communications électroniques sur les réseaux de communications électroniques ouverts au public, y compris ceux prenant en charge les dispositifs de collecte de données et d’identification. »

Le texte poursuit en indiquant que « II. – En cas de violation de données à caractère personnel, le fournisseur de services de communications électroniques accessibles au public avertit, sans délai, la Commission nationale de l’informatique et des libertés. ».

Le texte prévoit en outre, une obligation de notification à la personne physique concernée par la violation des données personnelles en ces termes : « Lorsque cette violation peut porter atteinte aux données à caractère personnel ou à la vie privée d’un abonné ou d’une autre personne physique, le fournisseur avertit également, sans délai, l’intéressé. ».

L’article 226-17-1 du code pénal nouveau dispose en effet que « Le fait pour un fournisseur de services de communications électroniques de ne pas procéder à la notification d’une violation de données à caractère personnel à la Commission nationale de l’informatique et des libertés ou à l’intéressé, en méconnaissance des dispositions du II de l’article 34 bis de la loi n° 78-17 du 6 janvier 1978, est puni de cinq ans d’emprisonnement et de 300 000 € d’amende. ».

Le texte prévoit enfin que « III. – Chaque fournisseur de services de communications électroniques tient à jour un inventaire des violations de données à caractère personnel, notamment de leurs modalités, de leur effet et des mesures prises pour y remédier et le conserve à la disposition de la commission. » Réflexions sur ces nouvelles obligationsPar l’effet de ces dispositions, la CNIL doit être dans « la confidence » de l’incident constitutif de la violation de sécurité, et ce rapidement. Mécaniquement, le rôle de la CNIL sera ainsi, in fine, de vérifier que le prestataire de services ayant collecté ou traitant les données personnelles se préoccupe concrètement de mettre en œuvre des mesures visant à garantir la sécurité des informations personnelles qu’il détient. Le texte comporte quelques imprécisions notamment le contenu de la notification reste vague : doit-il comporter une description de la faille ainsi que les moyens d’y remédier ? Le texte ne le précise pas. Il est probable que la CNIL exigera ces explications et plus particulièrement le descriptif des moyens mis en œuvre pour y remédier. Le responsable du traitement est en position délicate : il doit signaler à la CNIL une violation qui peut, le cas échéant, être révélatrice d’un manquement de sa part à ses obligations de sécurité. C’est pourquoi nous pensons qu’il voudra, en tout état de cause montrer, pour échapper à cette responsabilité :

Des incertitudes demeurent notamment sur la définition exacte de la notion de fournisseur de services. On pourrait aussi rapprocher cette notion du type de celles de l’article 6 de la loi n° 2004-575 du 21 juin 2004 pour la confiance dans l’économie numérique (LCEN) définissant ainsi « Les personnes dont l’activité est d’offrir un accès à des services de communication au public en ligne ». Ces définitions sont communément considérées comme se référant à des intermédiaires techniques. Certains juges ont ainsi pu appliquer ces définitions non seulement à des fournisseurs d’accès à l’Internet, mais aussi à des entreprises mettant à la disposition de leurs salariés un accès(1), ou s’agissant de l’intermédiaire d’hébergement, non seulement l’hébergeur au sens strict, mais aussi toute personne offrant des fonctions de stockage de données mises à disposition d’un public (Web 2.0). Cette approche de ces textes par la jurisprudence laisse penser que l’interprétation restrictive de l’article 34 Bis pourrait ne pas être retenue par des juges lesquels pourraient être tentés d’élargir la notion de fournisseur de services à toutes personnes exerçant une fonction de fourniture de services de communications électroniques, selon les circonstances et les faits de l’espèce, plutôt que de s’arrêter à celles ayant un statut d’opérateur au sens strict. Tout comme la LCEN, le texte intégré dans la loi par l’Ordonnance ne se réfère pas à une définition statutaire, mais à une définition fonctionnelle de l’activité. Il peut être noté aussi que, même en faisant une application littérale du texte et de la définition de « fourniture au public de services de communications électroniques sur les réseaux de communications électroniques ouverts au public », nous pensons qu’il pourrait être facilement considéré, par exemple, qu’un site Internet qui mettrait à disposition des visiteurs des fonctionnalités de publication de commentaires, pourrait être considéré comme un tel fournisseur. De même, par extension de cette logique, il pourrait être prudent de considérer que tout détenteur de données à caractère personnel sur un réseau « on line » doit se préparer à respecter les obligations de notification en attendant que l’interprétation du texte soit clarifiée par les juges et par la doctrine de la CNIL en la matière. Dans la situation actuelle d’incertitude, certaines entreprises auront une attitude prudente et notifieront, d’autres pas, ce qui pourra donner lieu à des contentieux. Les recommandations de la CNIL, sa pratique et doctrine, ainsi que des premières jurisprudences sont bien sûr attendues et ne tarderont pas à dessiner les contours de cette nouvelle obligation de notification. Pour terminer, l’esprit de la loi vise avant tout la sanction de la négligence et de l’indifférence des acteurs utilisateurs de données à caractère personnel en les mettant face à leurs responsabilités, face à la CNIL et aux personnes concernées. Communiquer l’existence de la violation de la sécurité, signifie y faire face. En cas de violation de la sécurité des données personnelles, la passivité des responsables des traitements concernés est désormais sanctionnable. (1) Cour d’Appel de Paris 4 Février 2005, BNP PARIBAS / WORLD PRESS ONLINE, décision rendue sous l’empire de la loi du 1er aout 2000 Téléchargez les présentations de cette session d’information en ligne. Raoul Fuentes – Avocat Cabinet Iteanu

Ceci est un extrait du livre collectif "Mythes et légendes des TIC" développé dans le cadre de l’association Forum ATENA, en rapport avec le sujet de cette lettre "Les moteurs de recherche". Si vous désirez obtenir la version complète PDF la plus récente du livre "Mythes et légendes des TIC", il est téléchargeable en : Si vous désirez commander la version papier c’est sur : MYTHE N° 2 : Cette liberté d’expression, si chère aux constituants de 1789, semble l’être encore plus à tous les adeptes pratiquants de l’internet. Suivant un raisonnement que n’aurait pas renié Karl Marx, la combinaison de la technologie numérique et la libre accession à l’information et à « la culture » permettrait enfin de pouvoir exercer pleinement cette liberté restée formelle avant l’avènement des réseaux internet. Ce double pari s’appuyant toujours invariablement sur la technique (rapidité de la diffusion, de la duplication, de la reproduction) pour soit échapper au juge soit le placer devant le fait accompli. Le web2.0 se développe assez largement sur le mythe de l’impuissance du juge sur internet, incapable de « censurer » la liberté d’expression ou seulement d’appliquer une loi plutôt qu’une autre. Ce mythe se fracassa notamment en 2002 avec l’emblématique affaire « Père-Noël.fr » et le forum « défense-consommateur.org » qui vit les propos outranciers tenus censurés par le juge et son auteur sévèrement condamné. La technique du constat d’huissier avait facilement permis de surmonter la prétendue difficulté du numérique. Jean-Claude Patin, Juritel

|

![]()

![]() 15 mars – soirée networking "comment passer de la connaissance à la prévision ?"

15 mars – soirée networking "comment passer de la connaissance à la prévision ?"

Forum Atena organise le 15 mars prochain une soirée networking, réservée à ses membres, sur le thème "comment passer de la connaissance à la prévision ?", avec l’intervention de Lioubomir Bouev (PDG de Litis).

Les outils de Business Intelligence, bien répandus, permettent d’analyser avec précision les données de l’entreprise. Mais la prévision reste un art difficile, reposant plus sur les intuitions, l’expérience et le jugement humain.

Les modèles mathématiques proposent parfois des résultats très divergents et augmentent la prise de risque.

Aussi l’approche neuronale, basée sur des algorithmes apprenants, démontre de plus en plus souvent sa performance. Que ce soit pour optimiser les besoins en supply chain, dans l’industrie, ou anticiper les comportements en marketing.

On notera, au passage, l’extraordinaire réussite de système Watson d’IBM qui a battu les meilleurs joueurs au jeu télévisé Jeopardy.

Nous vous présenterons les grands principes illustrés des résultats concrets.

Plus d’infos / inscriptions : http://www.forumatena.org/?q=node/350

Philippe POUX, Secrétaire Général Forum Atena

![]() Accessibilité et audiovisuel : de l’innovation sociale vers des opportunités de marché ?

Accessibilité et audiovisuel : de l’innovation sociale vers des opportunités de marché ?

The Artist, œuvre cinématographique muet en noir et blanc, de Michel Hazanavicius est-il à contre-courant à l’heure de la 3D stéréoscopique et à l’air de l’interactivité ?

Ce long-métrage français trouve des trésors d’inventivité pour s’élever au-delà du simple hommage du cinéma d’il y a un siècle, ose les passages sonores avec naturel, utilise des ressorts comiques et trouve dans ce noir et blanc un support magnifique.

Débordant d’amour du cinéma, The Artist n’a pas été spécialement inventé pour les sourds et malentendants. Et pourtant, les personnes concernées par certaines formes de surdité y sont très sensibles, et peuvent y voir un avantage. Ainsi peut-on relever des commentaires autour de critiques du film comme : « étant sourd, j’ai enfin pu voir mon premier film français au cinéma et je me suis marré à lire sur les lèvres des acteurs. Je peux déjà vous dire qu’ils ne baragouinent pas n’importe quoi et respectent bien les dialogues. Pour une fois que je comprends mieux qu’un entendant ^^. » -1

Avec de nombreuses récompenses et prix, The Artist a d’abord été annoncé comme faisant partie de la sélection Hors Compétition au Festival de Cannes 2011, avant de rejoindre la compétition deux jours seulement avant l’inauguration, et une semaine à peine après avoir été achevé. Il poursuit sa carrière avec dix nominations aux Oscars dont Jean Dujardin pour la catégorie Meilleur acteur pour la 84e cérémonie qui aura lieu le 26 février à Los Angeles.

Il s’agit donc d’un film dans le vent. L’inventivité, la créativité, quand elle est associée à l’intelligence et au talent, même à contre-courant, peut apporter de la valeur au plus grand nombre…

Qu’est-ce que l’accessibilité dans l’audiovisuel ?

A notre connaissance, The Artist n’a pas été produit dans un but d’accessibilité, mais aurait pu l’être, car celle-ci n’est pas encore intégrée dans le processus de production du contenu directement.

Qu’est-ce que l’accessibilité dans l’audiovisuel ? Les obligations légales s’orientent de plus en plus vers l’accessibilité et l’inclusion de tous publics dans le monde de l’audiovisuel. Il s’agit de rendre accessible des films pour tous publics, y compris les malentendants, sourds, malvoyants, aveugles, etc, mais pas seulement, puisque de plus en plus de séniors, mais pas seulement, sont concernés, à des degrés divers par ces situations de handicap.

La plupart des innovations sont aujourd’hui technologiques, se créent dans des laboratoires de recherche, et sont utilisées surtout en fin de la chaîne de valeur, au niveau de la distribution/diffusion. Les producteurs, réalisateurs et scénaristes sont extrêmement peu informés de ce qui se crée dans les laboratoires, et de ce qu’ils pourraient intégrer dès l’amont dans le processus de production.

Aujourd’hui, l’accessibilité se traduit essentiellement par de l’audio-description, du sous-titrage ou du langage des signes. Si les créatifs intègrent l’accessibilité en amont et directement dans le processus de production, avec un storytelling mono- ou transmédias, de nouvelles œuvres et de nouvelles expériences d’utilisateurs grand public vont voir le jour.

Par ailleurs, et de manière générale, les acteurs de la chaine de valeur sont peu informés des enjeux et des intérêts des uns et des autres qui la composent. La télévision connectée est à l’origine de certains rapprochements avec le monde des contenus (ayant-droits, diffuseurs, chaines de télévision), elles intégreront l’accessibilité. Mais les usages sont à réinventer, et cette nouvelle donne va fortement modifier les modèles socio-économiques, être à l’origine de recompositions des acteurs.

Le fait d’intégrer l’accessibilité dès l’amont dans le processus de création, permettra, lorsque c’est bien fait, d’envisager de mettre celle-ci aux services du plus grand nombre. En ce qui concerne par exemple le vibreur du téléphone mobile, ayant a priori été inventé pour des personnes en situation de handicap, l’ensemble du grand public l’utilise aujourd’hui.

Pourquoi créer un événement « Media4D » autour de l’accessibilité ?

Les industries de l’électronique grand public, de la recherche TIC et le monde de la création des contenus ne parlent pas le même langage. Or un film est exploité d’une manière ou d’une autre sur l’ensemble des supports et les acteurs de l’audiovisuel devront composer avec l’évolution de l’interactivité et des réseaux sociaux utilisés sur l’ensemble des écrans (cinéma, télévision, ordinateur, supports mobiles

L’ambition de «Media4D» est de rapprocher ces mondes pour dynamiser les marchés et favoriser l’apparition de nouveaux modèles socio-économiques.

Sous l’impulsion de professionnels issus de ces trois mondes, une première conférence européenne « Media 4D – Le Contenu Visuel face à l’Innovation Technologique : de l’innovation sociale aux opportunités de marché » aura lieu le 30 mars 2012 à Paris (s’informer).

Cette conférence a pour but de se faire rencontrer les acteurs de l’industrie du film, les chaines de télévision, instituts de recherche, associations professionnelles et d’utilisateurs, dont ceux concernés par différentes formes de handicap, les équipementiers, financeurs, législateurs/régulateurs et des représentants de la Commission Européenne. Cet événement sera aussi une plate-forme permettant à des entreprises régionales et nationales, dont notamment aux PME et TPE de nouer des contacts avec des acteurs européens.

Le keynote d’ouverture, qui mettra en lumière les intérêts communs du marché pour les différents acteurs en présence (équipementiers, éditeurs et créateurs de contenus, accessibilité) sera prononcé par Serge Foucher, Executive Vice President and Compliance Officer chez Sony Europe.

Ce sera l’endroit, où l’on accède à des exemples concrets, discute l’état de l’art de l’accessibilité dans le domaine de l’audiovisuel : seront passés en revue la R&D, la production de contenus, les besoins des utilisateurs. Les moyens de financement et les modèles économiques auront une place de choix dans les discussions.

C’est pourquoi, au coté de Holken Consultants, Forum ATENA soutient l’initiative et l’accompagne.

Quels débats ?

L’objectif des quatre tables rondes organisées lors de la conférence du 30 mars est d’une part de sensibiliser les producteurs, réalisateurs, scénaristes, les créatifs à inclure les outils ou d’idées d’accessibilité très tôt dans le processus de création. Car nous sommes convaincus que, lorsque l’accessibilité est incluse dès l’amont dans le processus de production, de narration (story telling) ou l’écriture du scénario, cela sera un départ pour la création de nouvelles œuvres, avec de la valeur ajoutée et susceptibles d’intéresser tous publics, pas seulement ceux en situation de handicap.

D’autre part, il s’agit de faire prendre conscience de l’importance et de la diversité des d’audiences concernées par l’accessibilité, domaine de l’e-inclusion, et de comprendre leurs besoins et leurs attentes, d’identifier d’éventuelles difficultés persistantes et manquement dans l’existant aujourd’hui.

Bien au-delà, il sera opportun d’ouvrir le champ, de mener la réflexion pour intéresser le grand public à ces spécificités, autrement dit : comment transformer celles-ci en valeur ajoutée pour un public a priori non concerné par l’accessibilité.

Sur cette base, les débats développeront les positions des différents intervenants autour de 4 axes avec :

- Quels films sont « accessibles » et s ‘adressent à tous publics ? Quel est le rôle / l’importance du mono, cross ou transmédia ? Quels exemples existent qui ont intégré l’accessibilité, si possible dès l’amont dans le processus de production ?

- Quel est l’état de l’art de la technologie en Europe en matière de e-Accessibilité / e-Inclusion ? Comment elle peut intéresser le processus de création de contenus ? Comment combiner utilement des expériences d’utilisateur par l’e-inclusion et les intérêts du marché ?

- Que vise le régulateur ? Quel impact de la réglementation sur la diffusion/la production ? Quelles obligations ? A quelles audiences s’adresse-t-on ? Quels sont leurs besoins spécifiques? Comment y intéresser aussi les publics les plus larges ?

- Quelles opportunités de marché, quelles nouvelles expériences d’utilisateurs, quels financements possibles ?

Cette conférence « Media 4D » se construit aussi sur :

- un « kick-off » meeting organisé par le MediaClub -4, où 6 personnalités ont débattu de ses mêmes enjeux et pointé surtout de quelle manière chacun intervient par rapport au sujet de l’accessibilité,

- la création du ÉCU E-Inclusion Film Award dans le cadre de ECU – Le Festival du Film indépendant européen, en partenariat entre ÉCU et Holken Consultants & Partners.

Ainsi la conférence «Média4D» fait échos à la création d’un prix sur la e-Inclusion qui a été défini comme une méthode de réalisation ou de production qui utilise de nouvelles formes d’innovation pour atteindre un auditoire public le plus large possible, que ce soit par l’utilisation de TIC, technologies de l’information et de communication ou par l’imagination individuelle pure.

Il nous paraît important de rappeler ici que le réalisateur Michel Hazanavicius disait a propos de son propre film The Artist "C’est compliqué de partir d’aussi bas pour monter aussi haut : ça ressemble à un conte de fées pour ce film perçu au départ comme un film handicapé, sourd-muet, un vilain petit canard."

À ses côtés, Thomas Langmann, producteur du film, exprime ce qui intéresse tout producteur : "On rêve toujours qu’on fait un film qui va plaire au plus grand nombre. Mais sur le papier ce n’était pas gagné au départ. Mais ce qui faisait les faiblesses du film, muet, en noir et blanc, est devenu sa force."-5

C’est précisément ce qui est visé avec le prix de ECU E-Inclusion Award et la conférence Media 4D associée : tenir compte des spécificités et besoins de certaines catégories de populations et de les rendre utile, voire de les transformer en valeur ajoutée au plus grand nombre.

-1 http://marvelll.fr/critique-the-artist/ consulté en février 2012

-4 In : http://www.lepoint.fr/culture/the-artist-carton-plein-aux-oscars-24-01-2012-1423038_3.php consulté en février 2012

Hadmut Holken – Holken(a)holkenconsultants.com

Managing Director Holken Consultants & Partners – Maître de conférences associée à l’Université de Paris 13, membre à la MSH Paris-Nord

Networked & Electronic Media/NEM Steering Board member

![]() Le rapprochement Arcep-CSA-ANFR se concrétise

Le rapprochement Arcep-CSA-ANFR se concrétise

En fait. Le 3 janvier, lors des vœux de l’Agence nationale des fréquences (ANFR), Eric Besson, ministre de l’Economie numérique, a exposé quelques avancées sur le « rapprochement » qu’il avait appelé de ses vœux il y a un an entre le CSA, l’Arcep et l’ANFR dans le domaine de la gestion des fréquences.

En clair. Contacté par Edition Multimédi@, le directeur général de l’ANFR, Gilles Brégant, assure qu’« il y a bien eu des progrès sur le “rapprochement” » que souhaite toujours Eric Besson, le ministre de l’Industrie en charge de l’Economie numérique. Bien que cet objectif ne soit curieusement pas évoqué dans son rapport France numérique 2020 publié le 30 novembre 2011, sa volonté politique à défaut de fusionner ces trois autorités administratives indépendantes au moins de les rapprocher. « Je vous confirme que [ce rapprochement] a progressé. Et deux annonces sont donc faites [par Eric Besson le 3 janvier] : d’une part l’installation de la “base maîtresse” des fréquences à l’ANFR, et d’autre part la création d’une capacité d’études à l’ANFR, destinée à être commune (puisqu’elle doit “éclairer le gouvernement et les autorités indépendantes”). Ce ne sont pas des orientations neutres ». L’an dernier, le 10 janvier 2011, le ministre avait été plus explicite en s’adressant à Gilles Brégant, alors nouvellement nommé à la tête de l’ANFR : « J’attends du nouveau directeur général de l’Agence qu’il contribue activement à ce rapprochement des trois autorités. (…) Les trois autorités

compétentes en matière de gestion des fréquences, le CSA, l’Arcep, ANFR, ont vocation à coopérer plus étroitement ». Beaucoup avaient alors interprété ces propos comme une « fusion » annoncée des trois autorités. « La généralisation de l’accès à Internet haut débit fixe et mobile rend la frontière entre le monde de l’audiovisuel et celui des télécommunications tous les jours plus poreuse » : « Nous devons en tirer toutes les conséquences », avait lancé le ministre.

A défaut d’en passer par la loi (d’où le CSA et l’Arcep tiennent leurs missions et leurs structures), le rapprochement CSA- Arcep-ANFR avance par synergies renforcées, optimisation des moyens et recrutements mutuels. Gilles Brégant est en effet l’ancien directeur technique du CSA. Son DG adjoint, Jean- Marc Salomon, vient d’être recruté également au CSA où il était aussi DG adjoint. Lui-même tout juste remplacé par Michel Combot, lequel était DG adjoint de l’Arcep. A l’heure des réductions budgétaires dans l’administration publique, une fusion serait pourtant la bienvenue. Le rapport « TV connectée » (1) va jusqu’à suggérer « la création d’une autorité unifiée»comme«[voie] plus pérenne».

(1) – Rapport remis à Eric Besson et Frédéric Mitterrand le 30 novembre 2011 par avec Takis Candilis (Lagardère), Marc Tessier (VidéoFutur), Philippe Levrier (ex-CSA) et Martin Rogard

Edition Multimédia n° 49 – janvier 2012 – Charles de Laubier – editionmultimedia(a)sfr.fr

Le « cloud computing » ne date pas d’aujourd’hui. Il a déjà été expérimenté d’une certaine façon dans l’exploitation des instruments financiers, dématérialisés depuis longtemps sur les salles de marché bancaires. Il avait déjà, sous cette organisation primitive, l’ambition de réduire drastiquement les coûts et les risques de transactions, et d’optimiser les profits par le recours systématique à l’échelle mondiale et 24H sur 24 aux meilleures ressources, expertises, et conditions de marché et de fiscalité. Mais, malheureusement, le démembrement excessif et la délocalisation rapide de ces opérations, sans renforcer leurs procédures de gestion et de contrôle sur une chaine de confiance numérique plus étendue, ont démultiplié les failles de sécurité et donné l’occasion à la cybercriminalité de se développer.

L’ensemble des fraudes recensées dans le monde par l’office européen de la cybercriminalité atteint 388 milliards € sur les 4 premiers mois de l’année 2011.

Ce chiffre est stupéfiant ! Au rythme de la croissance des utilisateurs (1MDS 1994/2004 ; 2MDS 2005/2010 ; 3MDS 2011/2015), comment endiguer ce phénomène dans le contexte actuel d’un élargissement du « Cloud Computing » à toutes les activités de marché ?

La Conférence de Prague en Novembre 2011 consacrée à l’ISSE 2011 (Information Security Solutions Conference) et organisée sous l’égide de l’EEMA, fut sans doute un tournant décisif dans la manière de répondre à ce défi du 21ème siècle.

Cette conférence animée par une centaine d’experts européens et mondiaux apporta les premières briques d’une nouvelle architecture de sécurité renforcée permettant d’endiguer les fraudes et les menaces réelles de la cybercriminalité.

Le Conférence de Prague a préconisé des mesures de sécurité beaucoup plus intégrées dans la chaîne de dématérialisation des transactions, pour mieux certifier la valeur probante des transactions aux utilisateurs. Elle a également proposé davantage de contrôles de conformité et de légalité dans les opérations traitées en « cloud computing » au niveau des hébergeurs et des opérateurs spécialisés, pour assurer leur interopérabilité sans risque, et leur certification intermédiaire, s’agissant finalement de transactions virtuelles exécutées pour le compte de leurs clients.

Les briques de sécurité et d’interopérabilité sont essentielles quand on sait que la dématérialisation des échanges collaboratifs repose sur une parfaite maîtrise technologique des identités numériques, des moyens d’authentification, des télés procédures documentaires, des mandats et signatures, des systèmes de commutation, de transmission, et de conservation, et enfin, sur des organes de certification et de révocation responsables d’une obligation de résultat.

La virtualisation des transactions opérées en « Cloud Computing », pour préserver durablement les réseaux de confiance numérique entre les opérateurs et leurs clients, s’appuie donc sur des systèmes de gestion et de dématérialisation documentaire dont les processus de certification intermédiaires garantissent aux utilisateurs la sécurité dans la gestion de leurs attributs de confiance, la légalité dans l’usage de leurs signatures, et enfin, la conformité, l’intégrité, la traçabilité et la pérennité des

transactions établies dans un contexte d’interopérabilité entre leurs opérateurs et ceux de leurs partenaires commerciaux et financiers (MDS Model Driven Security/ Open PMF Open Policy Management Framework/ MDSA Model-Driven Security Incident Monitoring and Analysis Automation).

L’ouvrage publié (1) par l’ISSE 2011 (Information Security Solutions Europe) dont la Conférence de Prague s’est fait l’écho avec les experts du WG5 Digital Identity & Regulatory Framework (SSEDIC Scoping the Single European Digital Identity Community/ Building thematic network for european e.ID) ) contribue non seulement à la normalisation des systèmes avancés (Collaborative De-Perimeterised Environment CDePE- ISO/IEC 27000), mais celui-ci apporte aussi des solutions opérationnelles, notamment pour l’envoi du courrier recommandé (ETSI-STF 402- Standardizing the Pan –European Infrastructure for registered electronic mail delivery). Cette solution de courrier recommandé électronique est basée sur les Directives 1999/93/EC et 2000/709/EC, sur la décision 2003/511.EC, et sur les services mobilisant, d’une part, les TSP (TrustService Providers) pour la signature électronique (génération et validation) et pour l’horodatage, et d’autre part, les Tiers de Confiance Applicatifs (TrustApplication Service Providers) et les Prestataires de Services de Certification Applicative (listes de révocation, Trustservice Status Lists Provider).

(1) ISSE 2011 « Securing Electronic Business Processes” European 2011 Conference Norbert Pohlmann/Helmut Reimer / Wolfgang Schneider EDS. / VIEWEG+ TEUBNER

Eric Blot-Lefevre

Président de l’Atelier Dématérialisation

![]() Mission économique en Egypte avec Ubifrance

Mission économique en Egypte avec Ubifrance

Cairo ICT, une référence égyptienne dans le domaine des TIC !

Le secteur tant public que privé est porteur d’affaires :

- acteur majeur, l’état égyptien est soit un acheteur direct comme dans le domaine du logiciel et des services informatiques, soit indirectement via ses programmes de soutien à l’achat de matériel informatique. Le domaine de l’e-gouvernement et des solutions liées au domaine des transports, de l’énergie sont donc à étudier.

- au niveau du secteur privé, les solutions destinées au secteur bancaire, de la géolocalisation, du software basique pour les entreprises, de la sécurité informatique et dans le domaine de la formation se développent.

Si la révolution de janvier 2011 et ses suites ont ralenti l’activité du secteur, celui-ci reste néanmoins l’un de ceux en ayant le moins souffert, du fait de l’utilisation toujours croissante des télécommunications. Il reste par ailleurs un de ceux offrant le plus de perspectives de développement à moyen terme. L’organisation du salon après les élections présidentielles de début 2012 est enfin stratégique puisque l’on peut s’attendre à une importante reprise de l’activité à cette période.

En parallèle du salon MET – Media and Entertainment Trends, Cairo ICT est devenu incontournable en Egypte dans le domaine des TIC.

Cairo ICT en quelques chiffres : + 200 exposants en 2010, 80000 visiteurs attendus pour cette 16ème édition.

Tous les opérateurs télécoms égyptiens, les décideurs gouvernementaux du secteur et les principales entreprises multinationales de hardware et de software (Microsoft, IBM, Apple, Xerox…) y seront représentés.

Sa portée est également régionale puisque de nombreuses compagnies du Moyen-Orient viennent y exposer ou le visiter.

Pour optimiser votre présence sur le salon Cairo ICT (26 au 29 avril 2012 – Egypte, Le Caire ) et du fait de la taille et du large panel représenté sur ce salon, un programme de rendez-vous sur mesure est organisé afin d’avoir l’assurance de rencontrer ses interlocuteurs-cible.

![]() Du 13 au 15 mars, 4 salons professionnels à ne pas manquer

Du 13 au 15 mars, 4 salons professionnels à ne pas manquer

Solutions Intranet et Travail Collaboratif

> Les outils, conseils, services, applications intranet, solutions d’entreprises collaboratives, réseaux sociaux d’entreprises…

> En savoir plus

CoIP

> Toutes les applications sur IP : convergence fixe / mobile, web conferencing, visio conférences, communications unifiées, solutions collaboratives, vidéo chat, IP centrex / IPBX, messagerie instantanée, IP-TV / IP-vidéo, centre d’appels…

> En savoir plus

Solutions Ressources Humaines

> Le salon des outils et services dédiés aux dirigeants d’entreprises, aux responsables des Ressources Humaines, de la Formation et des Systèmes d’Information.

> En savoir plus

Elearning Expo

> Salon elearning (salon de la formation à distance et en ligne)

> En savoir plus

![]() Innovation, numérique, logiciels libres… la Picardie à l’honneur

Innovation, numérique, logiciels libres… la Picardie à l’honneur

Rencontres de l’Innovation – 21 février 2012 à Saint-Quentin et 23 février 2012 à Soissons

Vous êtes entrepreneur, industriel, chercher, créateur ou repreneur d’entreprise ? Vous avez des projets d’innovation ? Organisées régulièrement dans différentes villes de l’Aisne, c’est l’occasion de découvrir des méthodes et des outils pour innover, rencontrer d’autres entreprises, des centres techniques et de recherche, bénéficier des dispositifs d’appui personnalisés.

> En savoir plus

Journées du Logiciel Libre avec Oisux à CLERMONT (60) – Vendredi 16 et samedi 17 mars 2012

Présentation des Logiciels Libres, ateliers, présentation d’outils, stands des intervenants et des partenaires. Avec une journée consacrée aux professionnels et une autre aux particuliers, venez découvrir ou redécouvrir les logiciels libres !

> En savoir plus

Colloque du numérique – Lundi 19 mars 2012 à Soissons

Des ateliers vous seront proposés sur l’E-éducation, l’E-culture/tourisme, l’E-santé et l’E-management. A la fin de cette journée, une table ronde de clôture sera organisée pour revenir sur les nouveaux usages dans le numérique.

> En savoir plus

![]() Du 3 au 5 avril, salon B-Ecommerce 2012

Du 3 au 5 avril, salon B-Ecommerce 2012

En cette année 2012 de toutes les frayeurs pour l’économie, les premiers indicateurs restent bons pour le Ecommerce. Toutefois, notre secteur d’activité reste adossé à la consommation, tout comme les autres. Cette santé insolente doit donc être mise sous étroite surveillance et les budgets, dépenses et recettes surveillés avec plus d’attention que jamais.

Dans ce paysage où le village Gaulois du Ecommerce résiste encore et toujours à l’envahisseur qu’est la crise, nous avons tous besoin de sécuriser les sources de revenus, d’en améliorer la rentabilité et d’être prêts pour les tournants technologiques à venir.

Ce nouvel opus de B-ecommerce vise précisément à mettre les Ecommerçants en contact avec les experts du milieu, au travers de conférences et de contacts sur leurs espaces d’exposition, afin de vous aider à mieux piloter votre entreprise à travers cette année 2012 qui sera clef pour tous !

B-Ecommerce accueillera 100 exposants et partenaires et proposera un contenu riche composé d’une keynote d’ouverture, de 12 conférences plénières et de 20 ateliers experts. En savoir plus.

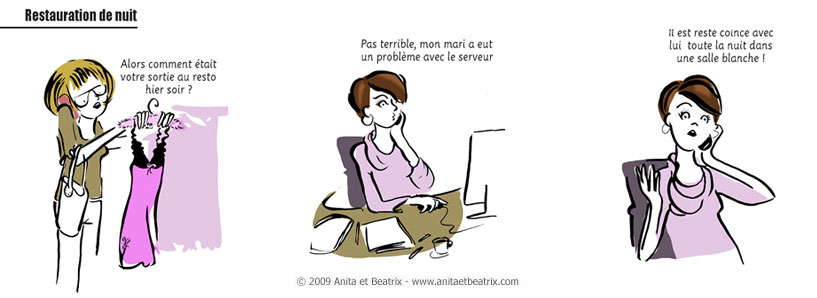

![]()

En informatique, un serveur est un ordinateur/machine contenant un logiciel dont le rôle est de répondre automatiquement à des demandes envoyées par des clients (logiciels ou ordinateurs) et donc d’offrir un service donné. Typiquement, la navigation sur Internet, le partage de fichiers ou le courrier électronique sont des applications qui font appel aux Serveurs.

La notion d’échanges client – serveur est devenue une composante de base dans la conception des logiciels. Les serveurs peuvent être de plusieurs types (ou offrant plusieurs services) : Serveur Web, fichiers, impressions, courriers, etc.), ces derniers sont hébergés dans des locaux spécifiques dédiés appelés « Salles Blanches Informatiques »

|

Jeudi 15 mars Lieu bientôt disponible Soirée Networking / Réseaux Neuronaux (réservée aux membres Forum Atena) Inscrivez-vous |

|

Vendredi 30 mars Siège du Groupe La Poste (Paris 15e) Media 4D Social Innovation Conference (en partenariat avec Holken Consulants & Partners) Informez-vous |

21 février (Saint Quentin) / 23 février (Soissons)

CCI de l’Aisne

Les rencontres de l’innovation 2012

Du 13 au 15 mars

Parc des Expos, Porte de Versailles

– Solutions Intranet et Travail Collaboratif

– CoIP

– Solutions Ressources Humaines

– Elearning Expo

16 et 17 mars

Clermont de l’Oise

Journées du Logiciel Libre

Lundi 19 mars

Soissons

Colloque du numérique

Du 3 au 5 avril

Parc des Expos, Porte de Versailles (Pavillon 4)

Salon Becommerce

Du 26 au 29 avril

Egypte

Mission Ubifrance – salon Cairo ICT